Big Data descreve um conjunto de problemas e suas soluções tecnológicas em computação aplicada com características que tornam seus dados difíceis de tratar. Há consenso de que três dessas características, as iniciadas pelos três ‘Vs’, são as principais: volume, velocidade e variedade. Apesar de Big Data ser uma expressão criada para ter impacto mercadológico, acabou definindo uma nova área de pesquisa.

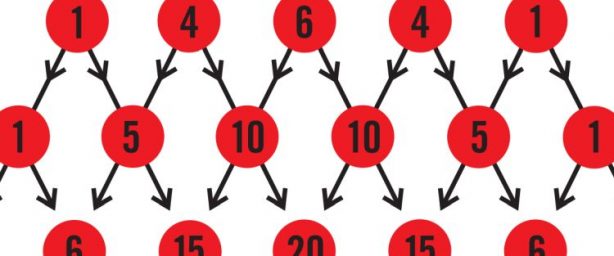

Como o termo Big Data faz supor, um dos desafios é a enorme quantidade de dados, ou seja, seu volume. Os sistemas tradicionais atuais não estão preparados para tratar certas coleções de dados que já temos ou vamos obter nos próximos anos. A previsão é que passaremos da faixa de muitos gigabytes (bilhões de bytes) ou poucos terabytes (trilhões) para a faixa de petabytes (milhares de trilhões) ou até mesmo exabytes (milhões de trilhões).

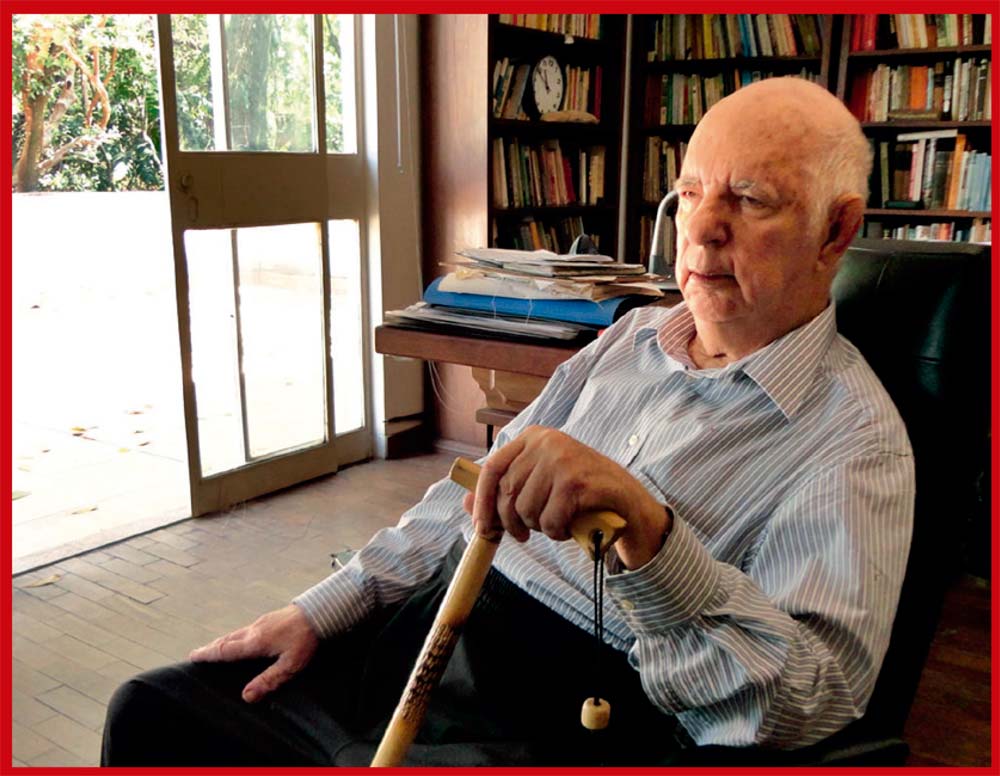

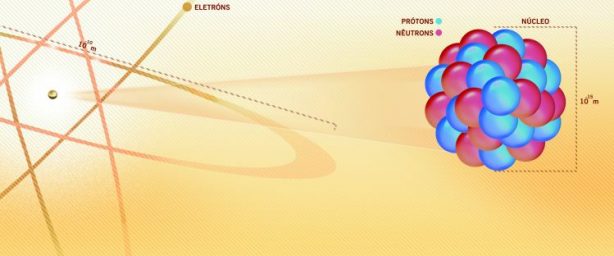

Para dar uma ideia, um disco rígido comum tem atualmente em torno de 1 terabyte. O LHC, o maior acelerador de partículas do mundo, no Centro Europeu de Pesquisas Nucleares (Cern), na Suíça, armazena 15 petabytes por ano de dados na forma original. É o equivalente a 15 mil discos rígidos cheios. Ao longo do tempo, os dados já somam 100 petabytes.

Velocidade significa que esses dados são enviados aos nossos sistemas com uma taxa de bytes por intervalo de tempo muito alta, tão grande que não temos como armazená-los todos. Assim, muitas vezes, somos obrigados a escolher dados para guardar e outros para descartar. Para armazenar aqueles 15 petabytes por ano, o Cern escolhe dados relevantes entre 15 petabytes gerados por segundo de operação do LHC.

Como saber o que guardar e guardar cada vez mais rápido é o desafio.

- O Grande Colisor de Hádrons, mais conhecido por LHC (sua sigla em inglês), gera 15 petabytes de informação por segundo, mas só são guardados 15 petabytes por ano. Saber o que guardar e guardar cada vez mais rápido também é fundamental na área de Big Data. (foto: Cern)

Mais três ‘Vs’

Variedade significa que os dados aparecem em formas diferentes. Nossos sistemas tradicionais são otimizados para processar dados que podem ser facilmente descritos na forma de tabelas, como uma planilha eletrônica, onde cada coluna tem tamanho constante ou previsível, mesmo que a quantidade de linhas seja muito grande. Entretanto, muitos dos novos tipos de dados têm formatos mais livres (textos, imagens etc.) ou com estruturas específicas (redes, por exemplo).

A partir desses três ‘Vs’, diversos autores propõem ainda outros conceitos, como veracidade, variabilidade ou valor. São outras preocupações importantes, como garantir que o dado seja verdadeiro e ainda válido no tempo.

Outra maneira de entender Big Data está na forma como os dados acabam sendo usados – muitas vezes, não planejada desde sua criação. A prática de guardar informação – qualquer que seja – permite que, mais tarde, exista uma disponibilidade que pode ser aproveitada em uma oportunidade não identificada previamente. No jargão da área, modelamos ou remodelamos os dados depois de obtê-los.

Basicamente, com a diminuição do custo de armazenamento de dados causada pela redução do preço dos discos rígidos e das fitas magnéticos, guarda-se tudo que é possível e, mais tarde, descobre-se como usar. Vale lembrar aqui que o preço de armazenar 1 megabyte em mídia magnética caiu de US$ 30 (cerca de R$ 60), em 1980, para menos de US$ 0,0001 (cerca de R$ 0,00005) neste ano.

Muitos desses dados estão ou podem ser relacionados, mesmo que criados de forma independente. Por exemplo, mensagens que são enviadas por redes sociais já foram cruzadas com os movimentos das bolsas de valores e com a evolução geográfica da gripe.

Essas características geraram novos desafios tecnológicos na computação e exigem novos tipos de sistemas, seja de equipamentos, seja de programas.

Geraldo Xexéo

Departamento de Ciência da Computação/ Instituto de Matemática

Programa de Engenharia de Sistemas e Computação/ Coppe

Universidade Federal do Rio de Janeiro