Em 2008, Sean Scott tinha um problema. O ativista e pesquisador norte-americano (1969-2009) enveredara pela ciência mais por necessidade do que por opção, depois de ver sua mãe e quatro de seus irmãos morrerem em decorrência de uma forma familiar de esclerose lateral amiotrófica (ELA), uma doença neurodegenerativa fatal. Por conta disso, Sean tinha se voluntariado sete anos antes para trabalhar no Instituto de Desenvolvimento de Terapias para a ELA, um centro privado de pesquisas nos Estados Unidos do qual acabaria por se tornar presidente.

Um dos projetos de Sean foi tentar replicar, nos laboratórios do instituto, os efeitos de tratamentos descritos em artigos científicos como sendo efetivos em aumentar a sobrevivência de camundongos com uma alteração gênica que simula a ELA. Cinco anos, 70 drogas e 18 mil camundongos depois, Sean chegaria a uma conclusão assustadora: nenhum dos tratamentos funcionava em suas mãos.

Sean não sabia – nem viria a saber, já que faleceria da doença no ano seguinte –, mas sua tragédia pessoal era um sintoma de algo disseminado na pesquisa acadêmica. Em 2011, a farmacêutica alemã Bayer relatou que conseguia reproduzir menos de um quarto dos achados sobre potenciais drogas para o tratamento de câncer e doenças cardiovasculares. Em 2012, a empresa norte-americana Amgen divulgou resultados ainda piores: 47 de 53 resultados publicados de pesquisa básica em câncer não puderam ser reproduzidos.

O que estaria acontecendo? A ciência biomédica, afinal, nos deu avanços inegáveis ao longo da história, como os antibióticos, as vacinas e os contraceptivos. Haveria algo de errado com o método científico?

Para tentar responder a essa pergunta, precisamos deixar o idealismo de lado e pensar em como a ciência é feita no mundo real.

A descrição clássica do método científico diz que, a partir de observações na natureza, um cientista concebe uma hipótese para explicar um fenômeno e desenha uma série de experimentos para testá-la. Começa então um processo que normalmente leva alguns anos de trabalho, ao final do qual se tem um conjunto de dados quase sempre obtido a muitas mãos. Na análise desses dados, tenta-se diferenciar o que são efeitos reais de resultados ocorridos ao acaso, o que envolve o uso de métodos estatísticos para diminuir a chance de falsos positivos.

Com os experimentos concluídos e os resultados analisados, é hora de juntá-los em um artigo científico, que inclui a justificativa da hipótese, a descrição dos procedimentos e dos resultados e uma discussão sobre suas implicações. O artigo é submetido ao corpo editorial de uma revista científica, na qual outros cientistas avaliarão o mérito do trabalho. Trabalhos mal conduzidos podem ser rejeitados ou receber sugestões para melhorarem. Se tudo correr bem, o artigo é aceito e publicado, a comunidade científica tem acesso aos resultados, e a ciência avança.

E como saber se a ciência está avançando de fato? Para termos certeza de que nossas hipóteses e teorias estão corretas, as observações que fazemos têm de ser consistentes e reprodutíveis por outros pesquisadores. Se um cientista relata um resultado, mas ninguém mais consegue obtê-lo em condições semelhantes, há grandes chances de ele ser fruto do acaso ou de um erro experimental.

O empreendimento científico se vale de vários freios e verificações para que esses casos sejam a exceção; no entanto, tentativas de replicar experimentos publicados sugerem que eles talvez sejam a regra. Será que a confiança na ciência não se justifica? Estamos nos desviando do processo original?

Existe uma distância considerável entre o método científico na teoria e na prática. Quando um cientista concebe uma hipótese, esta já nasce condicionada por uma série de fatores e vieses: a experiência do pesquisador, o orçamento, a infraestrutura disponível e aquilo que pode ter impacto em uma determinada área. Ou seja, hipóteses que possam cair no gosto dos editores das revistas científicas. Além disso, qualquer pesquisador já entra em um projeto com a expectativa de que os resultados venham a confirmar sua hipótese.

Ainda que um bom cientista seja aquele capaz de controlar esses vieses, as medidas necessárias para isso nem sempre são tomadas – seja por falta de tempo, dinheiro ou vontade. Experimentos em ciência biomédica básica raramente são feitos de maneira cega – sem que o experimentador conheça a identidade dos grupos experimentais –, e inúmeras decisões durante sua realização podem afetar os resultados do experimento.

Uma vez obtidos os dados, parte-se para a análise estatística, em que a regra vigente é usar métodos que gerem resultados falsos positivos em não mais do que 5% dos casos em que não existe um fenômeno real – o famigerado ‘p < 0,05’, que faz um resultado ser chamado de “estatisticamente significativo”. A margem de erro já é considerável se o método é bem aplicado: em cada 20 experimentos em que não há efeito algum, um deles gerará um resultado falso. Na prática, porém, essa taxa é bem maior.

Cientistas têm grande flexibilidade para analisar dados: para uma mesma hipótese, há várias maneiras de executar a análise, que podem levar a conclusões diferentes. Pior do que isso, a escolha frequentemente é determinada após o exame dos dados, o que significa que a própria hipótese acaba condicionada pelos resultados que deveriam testá-la – uma circularidade que subverte o método científico. Infelizmente, estatística costuma ser um buraco negro na formação de cientistas da área: métodos são passados por tradição oral dentro dos grupos de pesquisa, e a análise costuma ser realizada sem uma real compreensão de seu significado.

Caso um resultado “estatisticamente significativo” não seja encontrado, há grandes chances de o trabalho morrer nessa etapa, já que existe a crença de que resultados ‘negativos’ serão rejeitados pelas revistas científicas. Isso leva ao ‘efeito gaveta’: muitos experimentos acabam não publicados, não por problemas de execução, mas porque não confirmaram a hipótese original.

A expectativa pelo resultado positivo (e publicável) faz com que um mesmo experimento seja repetido várias vezes até gerar o resultado esperado – o que acontecerá mais cedo ou mais tarde, por força do viés ou do acaso. Qualquer resultado que vá em sentido contrário à hipótese original, por outro lado, será visto como suspeito e possivelmente desconsiderado – afinal, sempre se pode encontrar uma razão para atribuí-lo a alguma falha técnica ou a um erro de procedimento.

Análise concluída e resultado positivo encontrado, o artigo é submetido à revisão por pares. O processo costuma ter duas funções: (1) julgar a qualidade e o rigor metodológico dos experimentos e análises e (2) julgar se eles têm impacto e relevância suficientes para serem publicados em determinada revista. A primeira função, porém, não tem como ser cumprida de forma efetiva, já que, mesmo que os revisores sejam rigorosos, eles não têm acesso a tudo o que foi realizado em um projeto – como experimentos descartados, mudanças na análise e adaptações da hipótese.

Na prática, um artigo científico é uma narrativa construída por seus autores a partir de um conjunto selecionado de experimentos, de maneira a contar uma história lógica e impactante, mesmo que não reflita tudo o que foi realizado em um projeto. Isso faz com que ele não seja muito diferente de um perfil de sites de relacionamento: uma seleção de fotos reais, mas que constroem uma versão idealizada de uma pessoa.

No entanto, a crença dogmática da comunidade científica na revisão por pares faz com que um artigo publicado geralmente seja tomado como verdadeiro. A confiança no processo é tanta que, para o avanço da carreira de um cientista, não é necessário que os achados de um artigo sejam reproduzidos – a publicação em si basta para obter reputação, recursos de pesquisa e posições acadêmicas.

A ideia de que a revisão por pares seja capaz de garantir a reprodutibilidade, porém, é uma questão de fé, e não parece sustentar-se à luz da evidência disponível. E, com a ânsia dos pesquisadores de atingir as metas de impacto de certas revistas – o que com frequência leva a ‘atalhos’ metodológicos e ‘maquiagem’ de resultados –, não é absurdo perguntar se a pressão gerada pelo processo não prejudica a confiabilidade da ciência em vez de melhorá-la.

Um clássico estudo do epidemiologista greco-americano John Ioannidis, de 2005, sugere que, com o nível de rigor estatístico utilizado na ciência biomédica, a maior parte dos achados de pesquisa tende a ser falsa, especialmente em áreas com muitos grupos envolvidos, alta competição e flexibilidade de análise. E ainda que, dada a infrequência de estudos de replicação, não tenhamos como comprovar essa hipótese, os poucos dados existentes até agora têm lhe dado razão.

Tudo isso acontece no Brasil e no resto do mundo sem que necessariamente haja má intenção dos envolvidos. Os incentivos vão no sentido de publicar mais, mesmo sem muita certeza se o que se publica é sólido. Ainda assim, como atesta a história de Sean Scott, as consequências podem ser trágicas.

O crescimento da ciência feita no Brasil nas últimas décadas é apreciável. Dos anos 1990 para cá, o número anual de artigos publicados por brasileiros em revistas científicas indexadas aumentou de menos de 10 mil para quase 70 mil, colocando o país como o 14º produtor mundial de ciência. Tal aumento foi consolidado por meio de intensa cobrança por parte das agências de fomento – justamente para que se publicassem mais artigos. O processo é criticado por ter deixado de lado a ênfase na qualidade – segundo os críticos, o impacto da pesquisa brasileira não teria crescido. Os dados mundiais sobre reprodutibilidade, porém, trazem uma questão ainda mais urgente – quanto da produção científica nacional pode não ser reprodutível?

Algumas iniciativas internacionais buscaram reproduzir amostras sistemáticas de resultados em áreas específicas de pesquisa. Uma replicação de 100 estudos no campo da psicologia mostrou que a taxa de reprodutibilidade estava entre 36% e 47%, dependendo do critério utilizado para definir uma replicação de sucesso. Outra iniciativa, ainda em processo, pretende reproduzir artigos de alto impacto sobre biologia básica do câncer. Das 10 replicações publicadas até agora, em seis delas conseguiu-se reproduzir pelo menos parte dos resultados do artigo original. Das outras quatro, metade não os reproduziu, e metade não pôde ser interpretada devido a diferenças metodológicas.

Em nível nacional, porém, não existe nenhum dado sobre a reprodutibilidade da ciência publicada. É para preencher essa lacuna que iniciamos a Iniciativa Brasileira de Reprodutibilidade, um projeto multicêntrico para estimar a confiabilidade da ciência biomédica brasileira. A iniciativa, baseada no Instituto de Bioquímica Médica da Universidade Federal do Rio de Janeiro e patrocinada pelo Instituto Serrapilheira, pretende selecionar de 50 a 100 experimentos de artigos brasileiros em diferentes áreas da pesquisa biomédica, cada um dos quais será reproduzido em pelo menos três laboratórios diferentes.

Esse esforço exigirá o envolvimento de vários grupos de pesquisa no país, que serão incorporados ao projeto ao longo de 2018. A esperança é que esse esforço coletivo traga uma mudança cultural ampla, colocando a reprodutibilidade em pauta e engajando a comunidade científica do país para avaliá-la e discuti-la. A Iniciativa, que deve levar alguns anos para ser concluída, será a primeira avaliação sistemática da reprodutibilidade da ciência de um país, colocando o Brasil na vanguarda da busca por uma ciência melhor.

Um argumento levantado contra esse tipo de autocrítica é o de que questionar a ciência em público pode minar sua reputação, o que pode ser perigoso em um mundo já repleto de ‘pós-verdades’ e ‘falsas notícias’. Nada do que estamos propondo, porém, ignora os benefícios obtidos pela ciência e tecnologia para a humanidade. Pelo contrário, é exatamente por isso que devemos nos preocupar com a qualidade da pesquisa que fazemos, sobretudo em um momento de financiamento restrito.

Pode-se pensar na Iniciativa Brasileira de Reprodutibilidade como um exemplo do que a ciência tem de melhor: poucas atividades humanas investem tanto tempo questionando seus próprios métodos a fim de melhorá-los. A transparência desse processo é necessária para que o mérito de uma afirmação científica possa ser avaliado com base na evidência apresentada, e não na reputação de quem a afirma. Esse é o lema da Royal Society, a primeira sociedade científica: nullius in verba – que pode ser traduzido do latim como ‘nas palavras de ninguém’. É apenas apropriado, assim, que o processo de verificar nossa própria ciência seja uma responsabilidade compartilhada por todos nós.

Kleber Neves

Olavo B. Amaral

Instituto de Bioquímica Médica Leopoldo de Meis,

Universidade Federal do Rio de Janeiro

Está mesmo ocorrendo um aquecimento em todo o planeta? Existe alguma relação entre as vacinas e a ocorrência de autismo? Há evidências de que os neandertais acasalaram com os humanos modernos? Confira as respostas de especialistas.

As descobertas recentes do bóson de Higgs e das ondas gravitacionais, que deram veracidade a duas grandes teorias físicas, guardam entre si uma grande incompatibilidade. Essa divergênciaocorre desde a construção das bases dessas teorias, há cerca de um século, e reflete um conflito histórico entre célebres cientistas queserviu como motor do desenvolvimento científico.

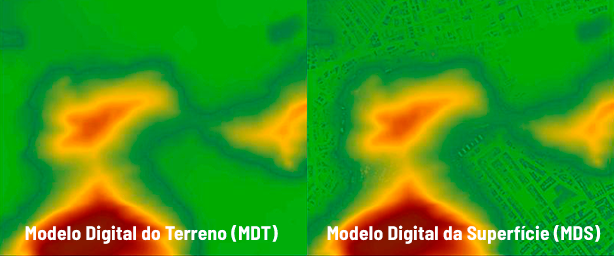

Cidades antigas escondidas, cavernas escuras, áreas de florestas fechadas, estrutura de prédios históricos. O sistema LiDAR, tecnologia de varredura a laser, descortina um mundo que estava escondido de nossa visão, com aplicações que vão do planejamento urbano à preservação florestal.

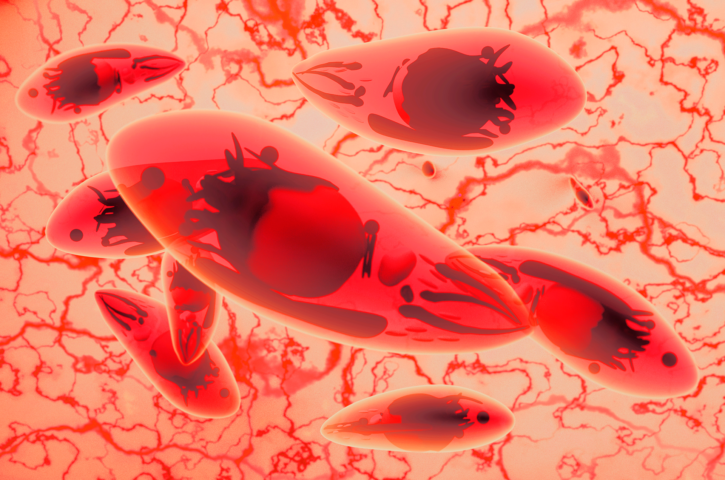

Doença causada pelo parasita Toxoplasma gondii atinge milhões de brasileiros, com consequências graves para a saúde pública. Pesquisadores estão propondo alternativas de tratamento para acelerar o processo de descoberta de novos medicamentos e assim beneficiar os pacientes.

A exploração do espaço voltou a ganhar momento, com a entrada em cena não só de novas agências espaciais, mas também de empresas que exploram comercialmente essa atividade. A tensão ideológica que marcou esse campo foi substituída pela cooperação

O mercado de sementes modificadas e dependentes de pesticidas tóxicos à saúde e ao ambiente está cada vez mais concentrado em algumas poucas megaempresas. É essencial visibilizar as formas de produção por trás do que comemos para alcançar alternativas saudáveis e justas

Há 50 anos, o lançamento do satélite Landsat-1 transformou nosso olhar sobre a superfície terrestre. Hoje, as técnicas de machine learning e deep learning promovem uma nova revolução, desta vez na “visão” dos computadores e no sensoriamento remoto do planeta

E se o Brasil tivesse um benefício social dado a cada criança, independentemente de suas famílias serem pobres, ricas ou de classe média? Injusto? Não é. O benefício infantil universal tem excelentes resultados em países que implementaram esse programa

O que acontece quando um professor de matemática, amante da poesia, analisa um dos poemas mais importantes da literatura brasileira? O resultado é a revelação de uma estrutura lógica complexa – e, para a maioria dos leitores, imperceptível – naqueles versos

Como os átomos se juntam para formar moléculas? A resposta para essa pergunta teve que não só vencer dogmas – muitos deles, ainda ‘vivos’ –, mas também esperar pelo desenvolvimento de uma teoria que explicasse os fenômenos atômicos e moleculares.

| Cookie | Duração | Descrição |

|---|---|---|

| cookielawinfo-checkbox-analytics | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Analytics". |

| cookielawinfo-checkbox-functional | 11 months | The cookie is set by GDPR cookie consent to record the user consent for the cookies in the category "Functional". |

| cookielawinfo-checkbox-necessary | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookies is used to store the user consent for the cookies in the category "Necessary". |

| cookielawinfo-checkbox-others | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Other. |

| cookielawinfo-checkbox-performance | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Performance". |

| viewed_cookie_policy | 11 months | The cookie is set by the GDPR Cookie Consent plugin and is used to store whether or not user has consented to the use of cookies. It does not store any personal data. |