Estudar o que ocorre na superfície terrestre com base em imagens de satélite sempre foi um anseio dos pesquisadores desde o início da corrida espacial, há cerca de seis décadas. Porém, esse sonho esbarrava principalmente na falta de capacidade computacional.

Mais recentemente, esse obstáculo foi vencido com o surgimento de plataformas dedicadas exclusivamente a essa tarefa, bem como o acesso da comunidade científica à chamada computação em nuvem.

Esse somatório de fatores permitiu não só a detecção de padrões de imagens e novos objetos, mas também seu acompanhamento ao longo do tempo com o uso cada vez maior de informação que, agora, pode ser processada em máquinas de alto desempenho e armazenada em grandes quantidades.

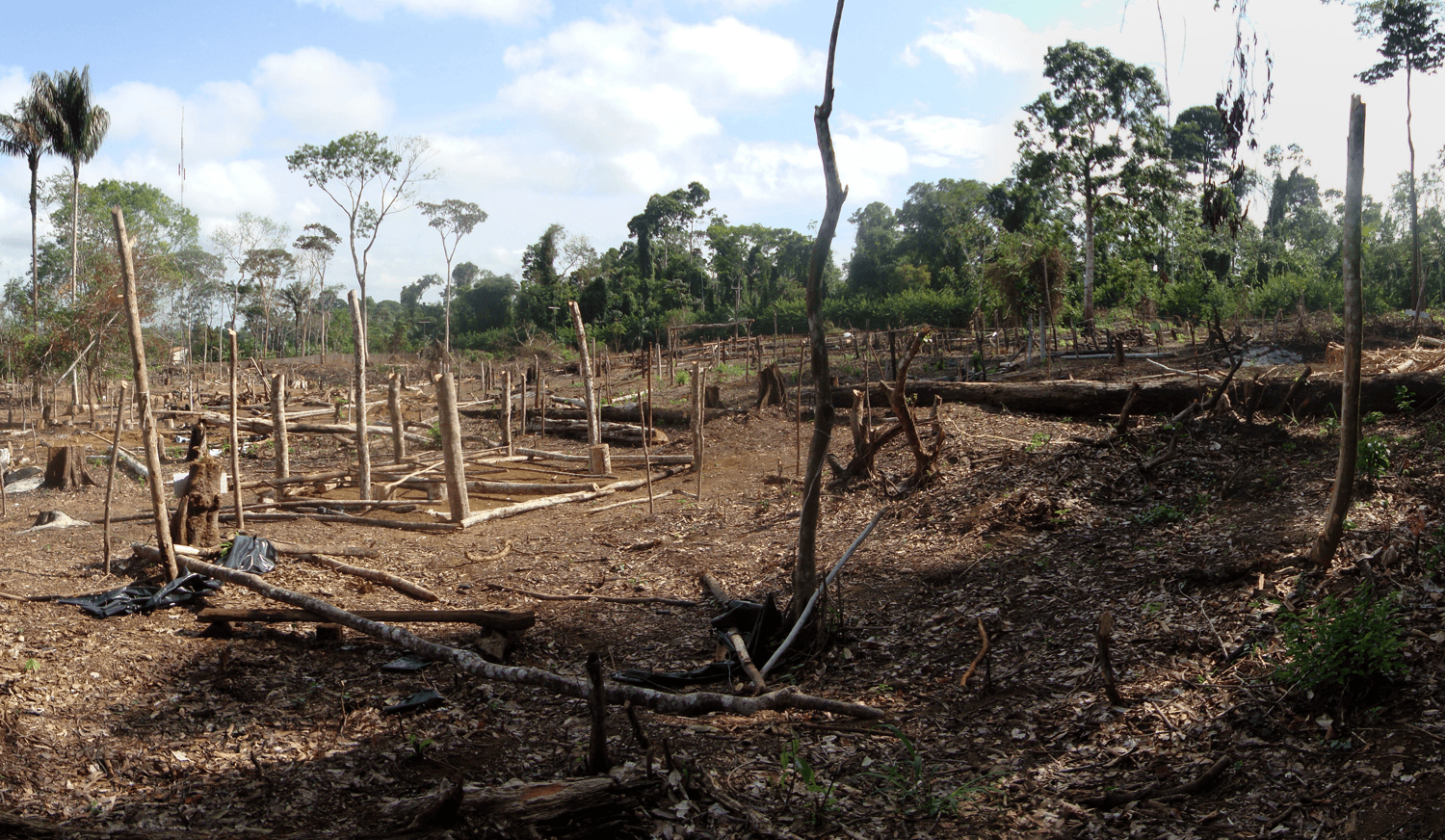

Em 7 de novembro de 2012, um dos canais oficiais do Google no YouTube postou um vídeo de uma região de Rondônia. Aquelas imagens de satélite mostravam a evolução do desmatamento na área desde 1975.

O vídeo ‒ que hoje tem centenas de milhares de visualizações ‒ foi compartilhado e publicado na mídia tradicional com tom de preocupação, pois era evidente a influência humana no local, que, já em 2009, estava quase sem a cobertura original de três décadas antes.

Aquelas imagens nos fazem lembrar de como a mudança da superfície terrestre pode ocorrer de forma mais brusca e intensa do que gostaríamos. O verde original da paisagem estava perto da extinção e havia cedido lugar a áreas agrícolas com formas retas quase nunca presentes no mundo natural quando vistas de cima.

Em abril de 2015, Rebecca Moore, cientista da computação e diretora responsável pelo desenvolvimento e pela manutenção da então já famosa ferramenta de localização Google Earth, estava no Brasil ‒ mais especificamente, em Foz do Iguaçu (PR) ‒, participando do Simpósio Brasileiro de Sensoriamento Remoto, organizado pelo Instituto Nacional de Pesquisas Espaciais (Inpe) e por pesquisadores e colaboradores da área.

Em sua palestra, a cientista divulgou uma novidade: Google Earth Engine. Essa ferramenta não era só uma evolução do Google Earth, mas também uma nova forma de se pensar sobre o processamento de dados de nosso planeta.

O processamento que Rebecca mostrou em sua apresentação estava sendo feito em tempo real, em um computador a milhares de quilômetros de distância dali. Mas, mais do que executar comandos a distância, Rebecca estava manipulando visualmente os dados e obtendo respostas em tempo real ‒ isso deixou pesquisadores presentes boquiabertos.

Até então, só poucos centros de pesquisa e instituições governamentais tinham capacidade computacional de armazenar e processar dados tão grandes ‒ talvez, nenhum de forma tão rápida.

O diferencial do Google Earth Engine baseia-se em avanços que estavam ocorrendo de forma paralela, como o crescimento do conceito de ‘computação em nuvem’, denominação da tecnologia que dá acesso a uma infraestrutura grande de computadores interconectados por uma rede de alto desempenho, onde usuários externos podem utilizar a infraestrutura pagando apenas pela capacidade computacional escolhida e de acordo com seu tempo de uso.

Com o tempo, muitos provedores passaram a oferecer serviços específicos, de planos exclusivos para hospedagem de portais (websites) a grandes volumes de armazenamento ‒ por vezes, por tempo limitado ‒ para pesquisadores que trabalham, por exemplo, com inteligência artificial. Para cada caso, há um plano e preços distintos.

Como a infraestrutura tende a ser mais centralizada, o preço pelo tempo de uso do equipamento (hardware) diminui, sendo possível aumentar a quantidade não só de processamento, como também de armazenamento, caso seu negócio ou processo cresça ao longo do tempo. Isso permite que o usuário final não precise investir nem na compra de servidores dedicados, nem na contratação de mão de obra especializada na administração e manutenção.

Grandes bases de dados livres ‒ como as de imagens de satélite da série Landsat, Sentinel e Modis ‒ passaram a ser armazenadas nesses imensos centros de processamento, diminuindo seus tempos de processamento, já que os arquivos podiam usar a própria infraestrutura de rede do centro em vez da internet ‒ justamente um dos diferencias da ferramenta apresentada por Rebecca.

Era evidentemente uma mudança significativa e sem retorno para o mundo da tecnologia.

O Google Earth Engine não se propõe a ter todas as ferramentas possíveis, mas, sim, a prover um ambiente de desenvolvimento amigável, por meio de uma interface web acessível de basicamente qualquer computador que tenha um navegador e uma conexão com a internet.

Todo o processamento realizado usando essa plataforma não é feito na máquina pessoal do usuário, mas, sim, de forma paralela, na nuvem de computadores do Google, o que possibilita o processamento de uma quantidade incrível de dados em pouquíssimo tempo. Mais: não é mais necessário baixar (download) os dados brutos para a máquina que fará o processamento, pois eles já estão armazenados no banco de dados da empresa.

Pela primeira vez na história, qualquer pesquisador ou mesmo curiosos tinham a chance de processar todo o acervo de imagens da Terra, o que antes só era possível de ser feito por agências espaciais governamentais, como a Nasa (EUA).

A escolha de desenvolver uma plataforma que oferece não só uma caixa de ferramentas, mas também uma interface de manipulação dos dados foi outro grande ponto-chave para o sucesso do Google Earth Engine.

O fato de usar em sua interface o JavaScript ‒ não muito popular entre pesquisadores ‒ é amenizado pela facilidade em encontrar vasto material de estudo sobre essa linguagem de programação na internet.

Atualmente, o serviço disponibiliza gratuitamente grande parte dos acervos de imagens derivadas de satélites e ainda possibilita ao usuário subir (upload) sua própria base de dados ‒ esta, muitas vezes, acaba usada pela comunidade de usuários para novos estudos.

Para usar o Google Earth Engine, basta um simples cadastro. Os resultados obtidos podem ser exportados e baixados localmente, e o código criado pode ser compartilhado por meio de um simples link e reprocessado novamente a qualquer momento, por qualquer outro usuário. Tudo isso gratuitamente.

Mas, para a comunidade, a relação com uma gigante da tecnologia nunca é tão simples quanto parece. É inevitável que haja questionamentos sobre a crescente dependência social em relação à imensa gama de produtos oferecidos por essas empresas e a uma possível falta de segurança na manutenção do conhecimento humano da forma mais livre e democrática possível.

Com isso, a própria empresa optou por fazer com que os códigos desenvolvidos pela comunidade de pesquisadores passassem a ser acessíveis a todos os usuários, garantindo maior transparência sobre o posicionamento que a empresa tem em relação a esse conhecimento de ponta e, assim, diminuindo os temores de que ele seja manipulado no futuro.

Com os anos, iniciativas semelhantes ao Google Earth Engine surgiram no mercado, com interfaces gráficas diferenciadas e, muitas vezes, usando outras linguagens de programação como forma de entrada para a criação de novas ferramentas e para as sequências de processos.

As opções de serviços podem variar. Vão desde os especializados em processamento de imagens de satélite de alta resolução ‒ quase sempre não gratuitas, como na plataforma do Google ‒ até aqueles mais híbridos, em que só parte do catálogo é gratuita.

Uma dessas iniciativas foi iniciada pela empresa Planet, que, além da criação de uma interface de manipulação on-line de dados planetários, oferece serviços (pagos) que usam algoritmos da inteligência artificial para criar um catálogo de objetos na Terra. Diferentemente do Google Earth Engine, as imagens da Planet são geradas por satélites de altíssima resolução da própria empresa.

As imagens de altíssima resolução ‒ que havia anos permitiam a visualização com mais detalhes do planeta por milhões de usuários por meio de ferramentas do próprio Google Earth ‒ passam a ser empregadas, agora, por empresas como a Planet, como dado de entrada para algoritmos de inteligência artificial que têm a capacidade de detecção automatizada de objetos, como navios, carros, casas, rodovias, árvores etc.

Com isso, cria-se um banco de dados cada vez maior e mais preciso de objetos vistos do espaço que podem ser catalogados graças tanto a uma constelação de pequenos satélites em órbita próxima à Terra, capturando imagens de altíssima resolução, quanto técnicas de inteligência artificial de ponta. No entanto, diferentemente da plataforma do Google, serviços mais especializados como esse não são gratuitos.

O crescimento da capacidade computacional e o paradigma da computação em nuvem vêm possibilitando novas formas de detecção de padrões nas imagens, bem como permitindo acompanhar esses padrões e objetos no tempo ‒ já que é possível analisar o comportamento dos mesmos por meio de uma quantidade cada vez maior de imagens.

Com uma constelação de satélites cada vez maior, menor é o tempo de visita e imageamento de um mesmo local. E, com cada vez mais imagens de uma mesma região, maior é a precisão da análise temporal, e, portanto, maior será o entendimento sobre os processos que acontecem na superfície terrestre.

A ideia de se analisarem processos que ocorrem ao longo do tempo na superfície terrestre usando imagens de satélite pode até parecer simples, mas por toda a história da ciência foi complicada e limitada pela falta de capacidade computacional. Quando essa nova tecnologia passou a estar disponível para um público maior, inevitavelmente, técnicas que antes só eram aplicadas a dados menores, agora, passam a ser usadas para a análise de séries temporais, utilizando imagens de satélite.

Muitas dessas técnicas – que vieram do mercado financeiro, que, tradicionalmente, sempre teve a necessidade de analisar processos aleatórios (estocásticos) – passaram a ser usadas para detectar perturbações na natureza, como ações de degradação, desmatamento e até processos de regeneração natural ocorridos na paisagem.

Grande parte dessas plataformas possibilita que usuários criem as próprias ferramentas e lógicas de processamento para os dados disponíveis. Como resultado, algoritmos desenvolvidos pela comunidade científica tornaram-se acessíveis por meio dessas plataformas.

As vantagens dessa acessibilidade são muitas: i) a popularização de certas técnicas tende a crescer significativamente; ii) o acesso ao poder de processamento necessário se torna mais democrático.

Com isso, mesmo pequenos laboratórios em países com pouco investimento em educação e ciência têm a chance de trabalhar com análises espaciais em escalas globais, o que, inclusive, acaba elevando o número de publicações desses pesquisadores em periódicos de alto impacto.

Nesse campo, muitos são os desafios. Apesar de o número de pesquisadores que passam a usar plataformas de processamento de dados terrestres na nuvem crescer a cada dia, membros da comunidade científica ainda encontram problemas não só por não terem experiência com linguagens menos populares no meio científico (por exemplo, JavaScript), mas também por não terem experiência alguma com programação em si.

O acesso a certas tecnologias vem se tornando mais democrático, mas estas, muitas vezes, impõem exigências técnicas que o usuário precisa dominar para ter acesso a elas. Além disso, muitas dessas plataformas não se comunicam entre si, o que é problemático na hora de se planejar o que aprender exatamente.

Vale ressaltar que o custo de se investir no aprendizado de uma nova linguagem ou ferramenta é alto e tem seus revezes: o conhecimento obtido ao estudar uma plataforma, por vezes, não pode ser aplicado ao entendimento de outra, que pode empregar outra linguagem.

Foi pensando nesse problema que iniciativas como a OpenEO surgiram. A OpenEO é um projeto financiado pela União Europeia que reúne cientistas da área de observação da Terra. O objetivo da iniciativa é criar uma tecnologia que permita aos pesquisadores usarem a linguagem de sua preferência (R, Python JavaScript etc.) para desenvolverem seus códigos e se conectarem de forma padrão a várias plataformas de processamento de dados espaciais ao mesmo tempo.

Portanto, com o uso de uma única linguagem, o usuário pode se conectar e processar dados de observação da Terra, usando não só o Google Earth Engine, mas também outras plataformas de forma integrada. A ideia é tão promissora que até funcionários da Google responsáveis pelo desenvolvimento do Google Earth Engine já fazem parte da equipe que tem como objetivo integrar sua ferramenta a outras.

Apesar de o OpenEO ainda estar em fase inicial, o certo é que o futuro da ciência da observação da Terra nunca foi tão promissor. E instigante, pois ainda não temos certeza de como essas mudanças irão afetar a vida de todos os integrantes desse planeta, o qual estamos, há décadas, observando a partir do espaço.

Eduardo Lacerda

Programa de Pós-graduação em Geografia,

Universidade Federal Fluminense

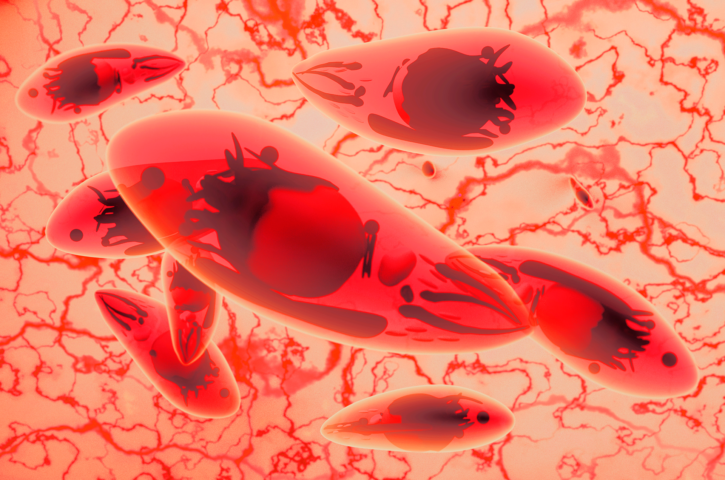

Doença causada pelo parasita Toxoplasma gondii atinge milhões de brasileiros, com consequências graves para a saúde pública. Pesquisadores estão propondo alternativas de tratamento para acelerar o processo de descoberta de novos medicamentos e assim beneficiar os pacientes.

A exploração do espaço voltou a ganhar momento, com a entrada em cena não só de novas agências espaciais, mas também de empresas que exploram comercialmente essa atividade. A tensão ideológica que marcou esse campo foi substituída pela cooperação

O mercado de sementes modificadas e dependentes de pesticidas tóxicos à saúde e ao ambiente está cada vez mais concentrado em algumas poucas megaempresas. É essencial visibilizar as formas de produção por trás do que comemos para alcançar alternativas saudáveis e justas

Há 50 anos, o lançamento do satélite Landsat-1 transformou nosso olhar sobre a superfície terrestre. Hoje, as técnicas de machine learning e deep learning promovem uma nova revolução, desta vez na “visão” dos computadores e no sensoriamento remoto do planeta

Um lagarto sul-americano guarda um fato peculiar: em sua fase reprodutiva, o organismo desse réptil é capaz de aumentar a geração de calor interno – fenômeno raro para um animal que depende da radiação solar como fonte de energia. Bem-vindos aos ‘mistérios’ dos teiús.

Milhares de anos depois de os ímãs terem sido descobertos, o estudo do magnetismo segue como uma das áreas mais pujantes da física. De lá para cá, novos fenômenos foram descobertos. Entre eles, um em que materiais magnéticos se comportam como líquidos.

Sem dúvida, rodovias trazem progresso. Mas elas têm efeitos nocivos para o meio ambiente: poluição, perda e degradação de vegetação nativa, bem como fragmentação da paisagem. Há outro problema (talvez, ainda mais preocupante): a morte de animais por colisão com veículos.

A forma líquida do mercúrio sempre intrigou as pessoas. Conhecido há milênios, esse metal passou da religião para a medicina e a indústria. A ciência mostrou que ele é tóxico. Mas seus efeitos nocivos para o ambiente e a saúde seguem até hoje – inclusive no Brasil

| Cookie | Duração | Descrição |

|---|---|---|

| cookielawinfo-checkbox-analytics | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Analytics". |

| cookielawinfo-checkbox-functional | 11 months | The cookie is set by GDPR cookie consent to record the user consent for the cookies in the category "Functional". |

| cookielawinfo-checkbox-necessary | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookies is used to store the user consent for the cookies in the category "Necessary". |

| cookielawinfo-checkbox-others | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Other. |

| cookielawinfo-checkbox-performance | 11 months | This cookie is set by GDPR Cookie Consent plugin. The cookie is used to store the user consent for the cookies in the category "Performance". |

| viewed_cookie_policy | 11 months | The cookie is set by the GDPR Cookie Consent plugin and is used to store whether or not user has consented to the use of cookies. It does not store any personal data. |